ЧОП Институт Экономики Управления и права.

Альметьевский филиал. Экономический факультет.

Кафедра «Финансы и кредит».

Реферат

по дициплине Теория вероятностей

Выполнила: студентка Ӏ-го курса 101гр

Фахреева Лейсан Ирековна.

Проверила:

Мельниченко Янина Ивановна.

2011 год

Введение

Теория вероятностей является одним из классических разделов математики. Она имеет длительную историю. Вероятностные и статистические методы в настоящее время глубоко проникли в приложения. Они используются в физике, технике, экономке, биологии и медицине. Особенно возросла их роль в связи с развитием вычислительной техники. Например, для изучения физических явлений производят наблюдения или опыты. Их результаты обычно регистрируют в виде значений некоторых наблюдаемых величин. При повторении опытов мы обнаруживаем разброс их результатов. Например, повторяя измерения одной и той же величины одним и тем же прибором при сохранении определенных условий (температура, влажность и т.п.), мы получаем результаты, которые хоть немного, но все же отличаются друг от друга. Даже многократные измерения не дают возможности точно предсказать результат следующего измерения. В этом смысле говорят, что результат измерения есть величина случайная.

Случай, случайность — с ними мы встречаемся повседневно: случайная встреча, случайная поломка, случайная находки, случайная ошибка. Этот ряд можно продолжать бесконечно. Казалось бы, тут лет места для математики—какие уж законы в царстве Случая! Но и здесь наука обнаружила интересные закономерности—они позволяют человеку уверенно чувствовать себя при встреча со случайными событиями.

Как наука теория вероятности зародилась в 17в. Возникновение понятия вероятности было связано как с потребностями страхования, получившего значительное распространение в ту эпоху, когда заметно росли торговые связи и морские путешествия, так и в связи с запросами азартных игр. Слово «азарт», под которым обычно понимается сильное увлечение, горячность, является транскрипцией французского слова hazard, буквально означающего «случай», «риск».

Азартными называют те игры, а которых выигрыш зависит главным образом не от умения игрока, а от случайности. Схема азартных игр была очень проста и могла быть подвергнута всестороннему логическому анализу. Первые попытки этого рода связаны с именами известных учёных—алгебраиста Джероламо Кардана (1501- 1576) и Галилео Галилея (1564—1642). Однако честь открытия этой теории, которая не только даёт возможность сравнивать случайные величины, но и производить определенные математические операции с ними, принадлежит двум выдающимися ученым—Блезу Паскалю (1623—1662) и Пьеру Ферма. Ещё в древности было замечено, что имеются явления, которые обладают особенностью: при малом числе наблюдений над ними не наблюдается никакой правильности, но по мере увеличения числа наблюдений всё яснее проявляется определенная закономерность. Всё началось с игры в кости.

Реклама

1.

Основное положение теории

Теория вероятности – это наука, занимающаяся изучением закономерностей массовых случайных явлений. Такие же закономерности, только в более узкой предметной области социально-экономических явлений, изучает статистика. Между этими науками имеется общность методологии и высокая степень взаимосвязи. Практически любые выводы сделанные статистикой рассматриваются как вероятностные. Особенно наглядно вероятностный характер статистических исследований проявляется в выборочном методе, поскольку любой вывод сделанный по результатам выборки оценивается с заданной вероятностью. С развитием рынка постепенно сращивается вероятность и статистика, особенно наглядно это проявляется в управлении рисками, товарными запасами, портфелем ценных бумаг и т.п. За рубежом теория вероятности и математическая статистика применятся очень широко. В нашей стране пока широко применяется в управлении качеством продукции, поэтому распространение и внедрение в практику методов теории вероятности актуальная задача. Как уже говорилось, понятие вероятности события определяется для массовых явлений или, точнее, для однородных массовых операций. Однородная массовая операция состоит из многократного повторения подобных между собой единичных операций, или, как говорят, испытаний. Каждое отдельное испытание заключается в том, что создается определенный комплекс условий, существенных для данной массовой операции. В принципе должно быть возможным воспроизводить эту совокупность условий неограниченное число раз.

Пример1. При бросании игральной кости "наудачу" существенным условием является только то, что кость бросается на стол, а все остальные обстоятельства (начальная скорость, давление и температура воздуха, окраска стола и т. д.) в расчет не принимаются.

Реклама

Пример 2. Стрелок многократно стреляет в определенную мишень с данного расстояния из положения "стоя"; каждый отдельный выстрел является испытанием в массовой операции стрельбы в данных условиях. Если же стрелку разрешено при разных выстрелах менять положение ("стоя", "лежа", "с колена"), то предыдущие условия существенно изменяются и следует говорить о массовой операции стрельбы с данного расстояния.

2. Абстракция событий

В математике событие – это любой объект или явление, которое может появиться или не появиться при определенных условиях. Причем создание этих условий не является обязательной причиной появления ожидаемого явления.

Различают невозможные, возможные и достоверные события.

Невозможные события – никогда не появляются при данных условиях (правильнее говорить, что вероятность появления такого события бесконечно мала).

Достоверные события – появляются всегда, если имеют место соответствующие условия. В данном случае между условиями и событиями однозначная причинно – следственная связь.

Возможные события – события, которые при одних и тех же условиях могут появляться, а могут не появляться, то есть создание условий в данном случае не гарантирует наступления события, что свидетельствует о неоднозначных или не прямых причинно – следственных связях между условиями и ожидаемыми событиями.

При изучении возможных событий возникает понятие частоты появления таких событий при многократном повторении наблюдений.

Частота события – это число случаев появления возможного события при определенных условиях. Очевидно, что это число f = 0,1,2,3…,n, где f – обозначение частоты, а n – ее максимально возможное значение. Также очевидно, что если f = n, то событие является достоверным, то есть наступает всегда.

Частота является простой малоточной мерой возможности. Более точной мерой возможности наступления события является относительная частоты (частость) – p=f/n

Так как 0≤f≤n, то 0≤p≤1, в данном случае n – общее число наблюдений или испытаний (иногда говорят шансов), а f – число случаев наступления возможного события.

3. Статистическое определение вероятности

Наиболее точной мерой возможности является предел относительной частоты (частости) при неограниченном увеличении числа испытаний. Его называют статистической вероятностью.

Р = lim ( m/n )

n→∞

Такое определение является чисто теоретическим, так как на практике неограниченное увеличение числа испытаний не возможно.

При подсчете числа элементарных исходов, составляющих события в классической схеме, часто используются известные формулы комбинаторики. Каждая из комбинаторных формул определяет общее число элементарных исходов в некотором идеализированном эксперименте по выбору наудачу m элементов из n различных элементов исходного множества E = {e1, e2, ..., en}.

При постановке каждого такого эксперимента строго оговорено, каким способом производится выбор и что понимается под различными выборками. Существуют две принципиально отличные схемы выбора: в первой схеме выбор осуществляется без возвращения элементов (это значит, что отбираются либо сразу все m элементов, либо последовательно по одному элементу, причем каждый отобранный элемент исключается из исходного множества). Во второй схеме выбор осуществляется поэлементно с обязательным возвращением отобранного элемента на каждом шаге и тщательным перемешиванием исходного множества перед следующим выбором. После того, как выбор тем или иным способом осуществлен, отобранные элементы (или их номера) могут быть либо упорядочены (т.е. выложены в последовательную цепочку), либо нет. В результате получаются следующие четыре различные постановки эксперимента по выбору наудачу m элементов из общего числа n различных элементов множества Е.

А. Схема выбора, приводящая к сочетаниям

Если опыт состоит в выборе m элементов без возвращения и без упорядочивания, то различными исходами следует считать m-элементные подмножества множества E, имеющие различный состав. Получаемые при этом комбинации элементов (элементарные исходы) носят название сочетания из n элементов по m, а их общее число N(W) определяется по формуле:

Cmn = n!/[m!(n - m)!] = n(n - 1)...(n - m + 1)/m!.

Для чисел Cmn, называемых также биномиальными коэффициентами, справедливы следующие тождества, часто оказывающиеся полезными при решении задач:

Cmn = Cn-mn (свойство симметрии),

Ckn+1 = Ckn + Ck-1n; C0n = 1 (рекуррентное соотношение),

C0n + C1n + ... + Cnn = 2n (следствие биномиальной формулы Ньютона).

Пример 1. Множество Е содержит 10 первых букв русского алфавита. Сколько различных алфавитов из трех букв можно составить из данного множества букв? Какова вероятность того, что случайно выбранный алфавит будет содержать букву «a»?

Решение Число различных алфавитов равно числу трехэлементных подмножеств множества Е (числу сочетаний из 10 элементов по 3):

N(W) = C310 = 10×9×8/(1×2×3) = 120.

Пусть событие A - случайно выбранный алфавит из трех букв, содержащий букву «a». Число элементов множества А равно числу всех возможных способов отобрать две буквы из девяти (из десяти букв исключена буква «a»), т.е. равно числу сочетаний из 9 элементов по 2: N(A) = C29 = 9×8/2 = 36.

Таким образом,

Р(A) = N(A)/N(W) = 36/120 = 0,3.

Б. Схема выбора, приводящая к размещениям

Если опыт состоит в выборе m элементов без возвращения, но с упорядочиванием их по мере выбора в последовательную цепочку, то различными исходами данного опыта будут упорядоченные m-элементные подмножества множества Е, отличающиеся либо набором элементов, либо порядком их следования. Получаемые при этом комбинации элементов (элементарные исходы) называются размещениями из n элементов по m, а их общее число N(W) определяется формулой:

Amn = Cmn×m! = n!/(n - m)! = n(n - 1)...(n - m + 1).

Если n = m, то опыт фактически состоит в произвольном упорядочивании множества Е, т.е. сводится к случайной перестановке элементов всего множества. Тогда N(W) = Ann = n!.

Пример 2. Группа, состоящая из 8 человек, занимает места за круглым столом в случайном порядке. Какова вероятность того, что при этом два определенных лица окажутся сидящими рядом?

Решение. Так как упорядочивается все множество из 8 элементов, то N(W) = A88 = 40320. Событию А благоприятствуют такие размещения, когда два отмеченных лица сидят рядом: всего 8 различных соседних пар мест за круглым столом, на каждой из которых отмеченные лица могут сесть двумя способами, при этом остальные 6 человек размещаются на оставшиеся места произвольно, поэтому по формуле о числе элементов прямого произведения множеств получаем N(A) = 2×8×6!. Следовательно Р(A) = N(A)/N(W) = 2/7.

В. Схема выбора, приводящая к сочетаниям с повторениями

Если опыт состоит в выборе с возвращением m элементов множества E = {e1, e2, ..., en}, но без последующего упорядочивания, то различными исходами такого опыта будут всевозможные m-элементные наборы, отличающиеся составом. При этом отдельные наборы могут содержать повторяющиеся элементы. Например, при m = 4 наборы {e1, e1, e2, e1} и {e2, e1, e1, e1} неразличимы для данного эксперимента, а набор {e1, e1, e3, e1} отличен от любого из предыдущих. Получающиеся в результате данного опыта комбинации называются сочетаниями с повторениями, а их общее число определяется формулой N(W) = Cmn+m-1.

Пример 3. В библиотеке имеются книги по 16 разделам науки. Поступили очередные четыре заказа на литературу. Считая, что любой состав заказанной литературы равновозможен, найти вероятности следующих событий: А - заказаны книги из различных разделов наук, В - заказаны книги из одного и того же раздела науки.

Решение. Число всех равновероятных исходов данного эксперимента равно, очевидно, числу сочетаний с повторениями из 16 элементов по 4, т.е. N(W)= C416+4-1 = C419.

Число исходов, благоприятствующих событию A, равно числу способов отобрать без возвращения четыре элемента из 16, поэтому Р(A) = N(A)/N(W) = C416/C419 » 0,47.

Число исходов, благоприятствующих событию В, равно числу способов выбрать один элемент из 16, поэтому Р(A) = N(A)/N(W) = C116/C419 » 0,004.

Г. Схема выбора, приводящая к размещениям с повторениями

Если выбор m элементов из множества E = {e1, e2, ..., en}, производится с возвращением и с упорядочиванием их в последовательную цепочку, то различными исходами будут всевозможные m-элементные наборы (вообще говоря, с повторениями), отличающиеся либо составом элементов, либо порядком их следования. Например, при m = 4 наборы {e1, e1, e2, e1}, {e2, e1, e1, e1} и {e1, e1, e3, e1} являются различными исходами данного опыта. Получаемые в результате различные комбинации называются размещениями, с повторениями, а их общее число определяется формулой

N(W)= nm.

Пример 4. Опыт состоит в четырехкратном выборе с возвращением одной из букв алфавита E = {а, б, к, о, м} и выкладывании слова в порядке поступления букв. Какова вероятность того, что в результате будет выложено слово «мама»?

Решение. Число элементов множества, равновероятных исходов равно числу размещений с повторениями из 5 элементов по 4 т.е. N(W)= 54. Слову «мама» соответствует лишь один возможный исход. Поэтому Р(A) = N(A)/N(W) = 1/54 » 0,0016.

Д. Схема упорядоченных разбиений

Пусть множество E состоит из m различных элементов. Рассмотрим опыт, состоящий в разбиении множества E случайным образом на s подмножеств E1, E2, ..., Es таким образом, что:

1. Множество Еi содержит ровно ni элементов, где i = 1, 2, ..., s.

2. Множества Еi упорядочены по количеству элементов ni.

3. Множества Еi, содержащие одинаковое количество элементов, упорядочиваются произвольным образом. Например, при n = 7, n1 = 2, n2 = 2, n3 = 3 разбиения {E1 = {e1, е2}, Е2 = {e3, е4}, Е3 = {e5, е6, e7}} и {E1 ={e3, е4}, Е2 ={e1, е2}, Е3 = {e5, е6, e7}} являются различными исходами данного опыта.

Число всех элементарных исходов в данном опыте определяется формулой

N(W) = n!/(n1! ×n2! × ... ×ns!).

Пример 5. Десять приезжих мужчин, среди которых Петров и Иванов, размещаются в гостинице в два трехместных и один четырехместный номер. Сколько существует способов их размещения? Какова вероятность того, что Петров и Иванов попадут в четырехместный номер?

Решение. Разбиения в данном опыте характеризуются следующими параметрами: s = 3, n = 10, n1 = 3, n2 = 3, n3 = 4. Тогда N(W) = 10!/(3!×3!×4!) = 4200.

Пусть событие А - Петров и Иванов попадут в одни четырехместный номер. Благоприятствующие событию А исходы соответствуют разбиениям со следующими параметрами: s = 3, n = 8, n1 = 3, n2 = 3, n3 = 2. Тогда N(A) = 8!/(3!×3!×2!) = 560. Искомая вероятность Р(A) = N(A)/N(W) = 560/4200 = 2/15.

4. Классическое определение вероятности

Введение этого понятия произошло не в результате однократного действия, а заняло длительный промежуток времени, в течении которого происходило совершенствование формулировки .Классическое определение вероятности было подготовлено исследованиями Граунта и Петти, результаты которых убедительно показали преимущества понятия частоты перед понятием численности. Понятие частоты, т.е. отношения числа опытов, в которых появлялось данное событие, к числу всех проведённых опытов, позволяет получить практические выводы, тогда как рассмотрение численностей оставляет исследователя в состоянии неопределённости.

Классическое определение вероятности (в весьма несовершенной форме) впервые появляется у Я.Бернулли, в его сочинении «Искусство предположений» (1713). В первой главе четвёртой части этой книги он писал: Вероятность же есть степень достоверности и отличается от неё, как часть от целого». В эту формулировку Я. Бернулли вкладывал современный смысл, что видно из его последующих слов: «Именно, если полная и безусловная достоверность, обозначаемая нами буквой α или 1(единицей),будет, для примера, предположена состоящий из пяти вероятностей, как бы частей, из которых три благоприятствуют существованию или осуществлению какого-либо события, остальные же не благоприятствуют, то будет говориться, что это событие имеет 3α/5 или 3/5 достоверности». В дальнейшем он писал об отношении числа благоприятствующих случаев к числу всех возможных, предполагая эти случаи равновозможными, но специально не оговаривая этого. Из этого высказываний следует, что Бернулли владел и статистическим понятием вероятности. Им было введено в рассмотрение и использование понятие вероятности случайного события как числа, заключённого между 0 и 1. Достоверному событию приписывалось единица (максимальное значение), а невозможному - нуль (минимальное значение). Было ясно сказано, что это число может быть определено двумя способами:1)как отношение числа случаев, благоприятствующих данному событию, к числу всех равновозможных случаев; 2)как частота события при проведении большого числа независимых испытаний. Можно сказать, что с этого момента начинается история теории вероятностей.

5. Геометрическая вероятность

В 1692 г.в Лондоне был издан английский перевод книги Х. Гюйгенса «О расчётах азартных играх».Переводчик книги – математик , врач и сатирик

Д.Арбутнов(1667-1735) добавил несколько задач, среди которых оказалась задача совсем иной природы, по сравнению с теми, которые рассматривались автором. Задача Арбутнота состояла в следующем: на плоскость наудачу бросают прямоугольный параллелепипед с рёбрами, равными а, в, с; как часто параллелепипед будет выпадать гранью ав? Решение задачи дано Т.Симпсоном (1710-1761) в книге «Природа и закон случая» (1740). Им предложена следующая идея решения. Опишем около параллелепипеда сферу и спроектируем из центра на её поверхность все рёбра, боковые грани и основания. В результате поверхность сферы будет разбита на шесть непересекающихся областей, соответствующих граням параллелепипеда. Симпсон подвёл итог: « Нетрудно заметить, что определённая часть сферической поверхности, ограниченная траекторией, описанной таким образом радиусом, будет находится в таком же отношении к общей площади поверхности , как вероятность появления некоторой грани к единице». Сказанное в полной мере выражает принцип разыскания геометрических вероятностей: вводится мера множества благоприятствующих событию случаев и рассматривается её отношение к мере множества всех возможных случаев. В данном случае полная мера сводится к площади поверхности шара.

Французский естествоиспытатель Бюффон (1707-1788),член Парижской академии наук (1733) и почётный член Петербургской академии наук (1766), дважды публиковал работы, посвящённые геометрическим вероятностям (1733,1777).Он рассматривал следующие задачи: 1)пол разграфлен на одинаковые фигуры (прямоугольники); на пол бросается монета, диаметр которой 2r меньше каждой из сторон прямоугольника, и монета целиком укладывается внутрь фигуры; чему равна вероятность того, что брошенная наудачу монета пересечёт одну или две стороны фигуры? 2) на плоскость, разграфленную равноотстоящими параллельными прямыми, наудачу бросается игла; один игрок утверждает, что игла пересечёт одну из прямых, другой – что не пересечёт; определить вероятность выигрыша каждого игрока;3) тот же вопрос для случая, когда игла бросается на плоскость, разграфленную на квадраты. После Бюффона задачи на геометрические вероятности стали систематически включатся в монографии и учёбные пособия по теории вероятностей.

6. Алгебра событий

закономерность случайный теория вероятность

Аксиоматическое определение вероятности.

Более верным математически определением вероятности, чем классическое, является аксиоматическое определение. Здесь события рассматриваются как элементы некоего конечного или бесконечного множества Ω. Для простоты возьмем конечное множество Ω=(w1,w2,…,wn), где wi это элементы множества Ω. Это множество Ω называют пространством элементарных событий, а его элементы wi – элементарными событиями.

Рассматривают такое подмножество F(Ω), которое обладает свойством ΩЄF. Событие Ө - пустое множество обозначим как невозможное событие ӨЄF(Ω). Тогда несовместимые события А и В будут определяться как

А ∩ В = Ө

(∩ - знак объединения множеств, U – пресечение множеств)

Тогда если ӨЄF, для любых событий АЄF и ВЄF верно следующее соотношение А∩ВЄF, АUВЄF

Такое множество F – называют алгебра событий.

Вероятностью события А называют такую числовую функцию Р(А), определенную на алгебре событий F, для которой справедливы следующие аксиомы:

1. Для любого АЄF верно Р(А)≥0 – аксиома неотрицательности.

2. Р(Ω)=1 – аксиома нормированности.

3. Если АЄF и ВЄF несовместимы (то есть А∩В=Ө), то Р(АUВ)=Р(А)+Р(В) – аксиома аддитивности.

7. Формула Бейеса

Пусть мы знаем вероятности событий А и В: Р(А) и Р(В). И пусть мы знаем условную вероятность события А по В: Р(A|B). Как найти условную вероятность P(B|A)? На этот вопрос отвечает формула Бейеса. Р(B|A)=P(A|B)·P(B)/P(A) (1) Разумеется этой формулой можно пользоваться только при условии, что Р(А)0. Формула Бейеса выводится из следующих равенств: Р(ВА)=Р(В|A)·P(A) (2) Р(AB)=Р(A|B)·P(B) (3) Р(ВА)=Р(AB) (4) так как пересечение событий В и А очевидно не зависит от порядка, в котором записаны А и В, т.е. ВА=AB. В случае Р(А)=0 принимаю обычно, что Р(В|A) есть величина неопределенная. 8.Формула полной вероятности.

Пусть имеем полную группу из n попарно непересекающихся событий  То есть То есть

, ,   , (6) , (6)

Пусть мы знаем условные вероятности некоторого события А по Еi: Р(А|Ei) и вероятности Р(Ei), i=1,...,n. Справедлива следующая формула полной вероятности для события А Р(А)=Р(A|E1)·P(E1)+...+P(A|En)·P(En) (7) Доказательство этой формулы вытекает из следующих равенств P(A)=P()=P(A(Ei))=P(AE1)+...+P(AEn)=Р(A|E1)·P(E1)+...+P(A|En)·P(En) (8) Из элементарной формулы Бейеса (1) и формулы полной вероятности (7) вытекает следующая более полная формула Бейеса

Р(Еi|A)=P(A|Ei)·P(Ei)/(Р(A|E1)·P(E1)+...+P(A|En)·P(En)) (9)

8. Полная группа событий

Несовместимые события – события, наступление которых одновременно при одном и том же опыте (испытании) невозможно. Например, выпадение двух граней кубика при одном броске невозможное событие.

Полная группа событий – совокупность однородных несовместимых событий, наступление одного из которых обязательно. Для примера с игральным кубиком полная группа событий будет выпадение каждой из шести граней.

И по классическому и по аксиоматическому определению вероятности очевидно, что вероятность наступления любого случайного события А будет равна 0<Р(А)<1. Краевые значения 0 и 1 будут определять неслучайные события – их делят на:

невозможные – ( Р(А)=0 или Р(Ө)=0) – наступление которых при данных условиях невозможно

достоверные – (Р(А)=1) – наступление которых при данных условиях обязательно.

Для несовместимых событий легко определить вероятность объединения (суммы) событий. Если Аi при i Є (1, n) несовместимые события, то вероятность суммы событий Аi равна сумме их частных вероятностей.

Р(А1+А2+,…,+Аn) = Р(А1)+Р(А2)+…+Р(Аn)

9. Независимость событий

Событие А называется независимым от события В, если наступление события А не оказывает никакого влияния на вероятность наступления события В.Вероятность одновременного наступления двух независимых событий равна произведению вероятностей этих событий.

Р(АВ) = Р(А)*Р(В) или Р(А1,А2,…,Аn) = Р(А1)*Р(А2)*…*Р(Аn)

Учитывая независимость событий и возможность появления двух событий одновременно тогда вероятность суммы двух независимых событий А и В более точно находят следующим образом:

Р(А+В) = Р(А) + Р(В) – Р(АВ),

где Р(АВ) – вероятность их одновременного появления

10. Условность событий

Безусловные события рассматриваются вне конкретных условий и обозначаются просто буквами А,В,С и т.д.

Условные события – рассматриваются при наступлении других событий. Они обозначаются например А/В – событие А при условии наступления события В и т.д.

Условную вероятность события А при наступлении события В находят следующим образом:

Р(А/В)=Р(АВ)/Р(В), если Р(В) ≠0

С помощью условных и безусловных вероятностей можно корректно определить зависимость или независимость событий.

События А,В и С называют независимыми если их безусловные вероятности равны их условным вероятностям:

Р(А)=Р(А/В)=Р(А/С)=Р(А/ВС)

Р(В)=Р(В/А)=Р(В/С)=Р(В/АС)

Р(С)=Р(С/А)=Р(С/В)=Р(С/АВ)

Это так называемое условие независимости событий. Если это условие нарушается, то события зависимы. Чем больше различия, тем сильнее зависимость.

Если рассмотреть вероятность совмещения (произведения) двух событий с учетом условности, то есть если принять что событие А наступает при условии наступления события В, то вероятность совмещения можно записать двумя способами:

Р(АВ)=Р(А)*Р(В/А)

Р(АВ)=Р(В)*Р(А/В)

Если брать три события, то количество способов, которыми можно записать вероятность их совмещения возрастает до двенадцати и т.д.

11. Понятие случайной величины

Случайная величина – величина, значение которой получается в результате пересчета или измерений и не может быть однозначно определено условиями его возникновения.

То есть случайная величина представляет собой числовые случайные события.

Случайные величины подразделяют на два класса:

Дискретные случайные величины – значения этих величин представляют собой натуральные числа, которым как отдельным событиям сопоставляются частоты и вероятности.

Непрерывные случайные величины – могут принимать любые значения из некоторого промежутка (интервала). Учитывая, что на промежутке от Х1 до Х2 числовых значений бесконечное множество, то вероятность того, что случайная величина ХiЄ(Х1,Х2) примет определенное значение, бесконечно мала. Учитывая, что невозможно перечислить все значения непрерывной случайной величины, на практике пользуются средним значением интервала (Х1,Х2).

Для дискретных случайных величин функция у=Р(х) - называется функцией распределения случайной величины и имеет график – его называют многоугольник распределения.

Различают следующие группы числовых характеристик: характеристики положения (математическое ожидание, мода, медиана, квантиль и др.), рассеивания (дисперсия, среднеквадратичное отклонение и др.), характеристики формы плотности распределения (показатель асимметрии, эксцесса и др.).

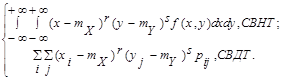

Математическим ожиданием (средним значением по распределению) называется действительное число, определяемое в зависимости от типа СВ Х формулой:

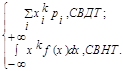

mX = M[X] =

Математическое ожидание существует, если ряд (соответственно интеграл) в правой части формулы сходится абсолютно. Если mX = 0, то СВ Х называется центрированной (обозначается  ). ).

Свойства математического ожидания:

M[C] = C,

где С - константа;

M[C×X] = C×M[X];

M[X+Y] = M[X]+M[Y],

для любых СВ X и Y;

M[X×Y] = M[X]×M[Y] + KXY,

где KXY = M[  ] - ковариация СВ X и Y. ] - ковариация СВ X и Y.

Начальным моментом k-го порядка (k = 0, 1, 2, ...) распределения СВ Х называется действительное число, определяемое по формуле:

nk = M[Xk] =

Центральным моментом k-го порядка распределения СВ Х называется число, определяемое по формуле:

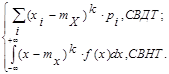

mk = M[(X-mX)k]=

Из определений моментов, в частности, следует, что: n0 = m0 = 1, n1 = mX, m2 = DX = sX2.

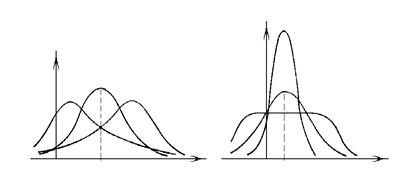

Модой СВНТ называется действительное число Mo(X) = x*, определяемое как точка максимума ПР f(x). Мода может иметь единственное значение (унимодальное распределение) или иметь множество значений (мультимодальное распределение).

Медианой СВНТ называется действительное число Mе(X) = x0, удовлетворяющее условию: P{X<x0} = P{X³x0} или F(x0) = 0,5.

Квантилем уровня р называется действительное число tp, удовлетворяющее уравнению: F(tp) = p. В частности, из определения медианы следует, что x0 = t0,5.

Дисперсией СВ Х называется неотрицательное число D[X] = DХ, определяемое формулой:

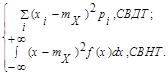

DX = M[(X-mX)2] = M[X2] - mX2 =

Дисперсия существует, если ряд (соответственно интеграл) в правой части равенства сходится. Свойства дисперсии:

D[C] = 0, где С - константа;

D[C×X] = C2×D[X];

D[X-C] = D[X],

дисперсия, очевидно, не меняется от смещения СВ X;

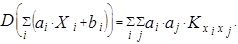

D[X + Y] = D[X] + D[Y] + 2×KXY,

где KXY = M[  ] - ковариация СВ X и Y; ] - ковариация СВ X и Y;

Неотрицательное число sХ =  называется среднеквадратичным отклонением СВ X. Оно имеет размерность СВ Х и определяет некоторый стандартный среднеквадратичный интервал рассеивания, симметричный относительно математического ожидания. (Величину sХ иногда называют стандартным отклонением). СВ Х называется стандартизованной, если mX = 0 и sХ = 1. Если величина Х = const (т.е. Х не случайна), то D[X] = 0. называется среднеквадратичным отклонением СВ X. Оно имеет размерность СВ Х и определяет некоторый стандартный среднеквадратичный интервал рассеивания, симметричный относительно математического ожидания. (Величину sХ иногда называют стандартным отклонением). СВ Х называется стандартизованной, если mX = 0 и sХ = 1. Если величина Х = const (т.е. Х не случайна), то D[X] = 0.

Показателем асимметрии ПР является коэффициент асимметрии (“скошенности”) распределения: A = m3/s3X. Показателем эксцесса ПР является коэффициент эксцесса (“островершинности”) распределения: E = (m4/s4X)-3. В частности, для нормального распределения E = 0.

Упорядочная совокупность n случайных величин (СВ) Х1, Х2, ..., Хn, рассматриваемых совместно в данном опыте, называется n-мерной СВ или случайным вектором и обозначается  = (Х1, Х2, ..., Хn). = (Х1, Х2, ..., Хn).

Функцией распределения (ФР) n-мерного случайного вектора называется функция n действительных переменных х1, x2, ..., xn, определяемая как вероятность совместного выполнения n неравенств: F(x1, x2, ... xn) = P{ X1 <x1, X2 <x2,..., Xn<xn}. В частности, для двумерного случайного вектора (X, Y) по определению ФР имеем: F(x, y) = P{X<x, Y<y}. ФР F (х, у) обладает следующими свойствами:

1. 0 £ F(x, у) £ 1;

2. F(x, у) - неубывающая функция своих аргументов;

3.

4.

Свойство 4 обычно называют условием согласованности. Оно означает, что ФР отдельных компонент случайного вектора могут быть найдены предельным переходом из функции совместного распределения этих компонент. Вероятность попадания случайной точки на плоскости (X, Y) в прямоугольник со сторонами, параллельными осям координат, может быть вычислена с помощью ФР по формуле:

P{x1 £X<x2, y1 £Y<y2} = F(x1, y1)+ F(x2, y2)- F(x1, y2)- F(x2, y1).

Двумерный случайный вектор (X,Y) называется случайным вектором дискретного типа (СВДТ), если множество его возможных значений G(x, y) не более чем счетно. Ее закон распределения можно задать двумерной таблицей из перечня возможных значений пар компонент {(хi, yi) | (хi, yi) ÎG(x, y)} и соответствующих каждой такой паре вероятностей pij = P{X = xi, Y = yj}, удовлетворяющих условию

Двумерный случайный вектор (X, Y) называется случайным вектором непрерывного типа (СВНТ), если существует такая неотрицательная функция f(x, y) называемая плотностью распределения (ПР) вероятностей случайного вектора, что:

f(x, y) =  , тогда F(x, y) = , тогда F(x, y) = . .

ПР вероятностей обладает следующими свойствами:

f(x, y) ³ 0, (x, y) ÎR2;

- условие нормировки. - условие нормировки.

ПР вероятностей отдельных компонент случайного вектора выражаются в виде интегралов от совместной плотности:

f(x) = f(y) = f(y) = . .

Вероятность попадания случайной точки в произвольную квадрируемую область S на плоскости определяется по формуле

P{(X, Y) ÎS}= . .

Условной плотностью распределения вероятностей случайной компоненты X при условии, что компонента Y приняла определенное значение у, называется функция f(x/y) действительной переменной х Î R: f(x/y) = f(x, y)/f(y). Аналогично определяется условная плотностью распределения вероятностей случайной компоненты Y при условии, что компонента X приняла определенное значение x: f(y/x) = f(x, y)/f(x). СВ X1, X2, ..., Хn называются независимыми (в совокупности), если для событий {XiÎ Bi}, i = 1, 2, ..., n, где B1, B2, ... Bn - подмножества числовой прямой, выполняется равенство: P{X1 Î B1, X2 Î B2, ... XnÎ Bn} = P{X1 Î B1}×P{X2 Î B2}× ... ×P{XnÎBn}.

Теорема: СВ X1, Х2, .... Хn независимы тогда и только тогда, когда в любой точке x = (x1, x2, ..., xn) имеет место равенство: F(x1, x2, ..., xn) = F(x1) ×F (x2) × ... ×F (xn) (или f(x1, x2, ..., xn) = f(x1) ×f(x2) × ... ×f(xn)).

Для двумерного случайного вектора (X, Y) вводятся следующие числовые характеристики.

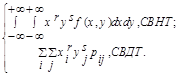

Начальным моментом порядка r + s случайного вектора (X, Y) называется действительное число nr,s, определяемое формулой:

nr,s = M[XrYs] =

Начальный момент nr,s существует, если интеграл (соответственно ряд) в правой части равенства абсолютно сходится. В частности, nr,0 = M[Xr] - соответствующие начальные моменты компоненты X. Вектор с неслучайными координатами (mX, mY) = (n1,0, n0,1) называется математическим ожиданием случайного вектора (X, Y) или центром рассеивания.

Центральным моментом порядка r + s случайного вектора (X, Y) называется действительное число mr,s определяемое формулой

mr,s = M[(X-mX)r (Y-mY)s] =

Центральный момент mr,sсуществует, если интеграл (соответственно ряд) в правой части равенства абсолютно сходится. Вектор с неслучайными координатами (DX, DY) = (m2,0, m0,2) называется дисперсией случайного вектора.

Центральный момент m1,1 называется корреляционным моментом (ковариацией): KXY = M[  ] = M[(X-mX)×(Y-mY)] = M[XY]-mXmY. ] = M[(X-mX)×(Y-mY)] = M[XY]-mXmY.

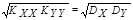

Коэффициентом корреляции двух случайных компонентов X и Y случайного вектора является нормированная ковариация

rXY = KXY/(sXsY).

Свойства ковариации (и коэффициента корреляции):

KXX = DX, KYY = DY, (rXX = rYY = 1);

KXY = KYX, (rXY = rYX);

|KXY|£ , (|rXY |£ 1). , (|rXY |£ 1).

Ковариационный момент и коэффициент корреляции определяет степень линейной зависимости между X и Y. Условие |rXY| = 1 необходимо и достаточно, чтобы СВ X и Y были связаны линейной зависимостью Х = a×Y + b, где a и b - константы. СВ, для которых KXY = 0 (rXY = 0), называются некоррелированными. Из независимости случайных величин Х и Y вытекает их некоррелированность (обратное, вообще говоря, неверно).

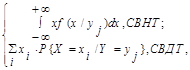

Условным математическим ожиданием компоненты Х при условии, что Y приняла одно из своих возможных значений yj, называется действительное число определяемое формулой:

mX/Y = M[X/Y = yj] =

где Р{X = xi /Y = yj} =  , pij = Р{X = xi ,Y = yj}. , pij = Р{X = xi ,Y = yj}.

Условной дисперсией компоненты Х при условии, что Y приняла одно из своих возможных значений yj, называется действительное число определяемое формулой:

DX/Y = D[X/Y = yj] =

Приведенные выше формулы для числовых характеристик двумерного случайного вектора без труда обобщаются на случай n-мерного случайного вектора (Х1, Х2, ..., Хn). Так, например, вектор с неслучайными координатами (m1, m2, ..., mn), где mi - математическое ожидание СВ Хi, определяемое формулой

mi = M[Xi] = , ,

называется центром, рассеивания случайного вектора.

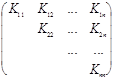

Ковариационной матрицей n-мерного случайного вектора  = (Х1, Х2, ..., Хn) называется симметрическая матрица, элементы которой представляют собой ковариации соответствующих пар компонент случайного вектора: = (Х1, Х2, ..., Хn) называется симметрическая матрица, элементы которой представляют собой ковариации соответствующих пар компонент случайного вектора:

K =  , ,

где Кij = M[  ] - ковариация i-й и j-й компонент. ] - ковариация i-й и j-й компонент.

Очевидно, что Кii = М[Xi2] -дисперсия i-й компоненты.

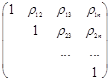

Корреляционной матрицейn-мерного случайного вектора называется симметрическая матрица, составленная из коэффициентов корреляции соответствующих пар компонент случайного вектора:

C =  , rij = , rij =  - коэффициент корреляции i-й и j-й компоненты. - коэффициент корреляции i-й и j-й компоненты.

Заключение

Таким образом, рассмотрев теорию вероятности, ее историю и положения и возможности, можно утверждать, что возникновение данной теории не было случайным явлением вы науке, а было вызвано необходимостью дальнейшего развития технологии и кибернетики, поскольку существующее программное управление не может помочь человеку в создании таких кибернетических машин, которые, подобно человеку, будут мыслить самостоятельно. И именно теория вероятности может способствовать появлению искусственного разума. «Процессы управления , где бы они ни протекали – живых организмах, машинах или обществе,- происходят по одним и тем же законам», - провозгласила кибернетика. А значит, и те, пусть еще не познанные до конца, процессы, что протекают в голове человека и позволяют ему гибко приспосабливаться к изменяющейся обстановке, можно воспроизвести искусственно в сложных автоматических устройствах. Важнейшим понятием математики является понятие функции, но почти всегда речь шла об однозначной функции, у которой одному значению аргумента соответствует только одно значение функции и функциональная связь между ними четко определенная. Однако в реальности происходят случайные явления, и многие события имеют не определенный характер связей. Поиск закономерностей в случайных явлениях - это задача раздела математики теория вероятности. Теория вероятности является инструментом для изучения скрытых и неоднозначных связей различных явлений во многих отраслях науки, техники и экономики.

Теория вероятности позволяет достоверно вычислить колебания спроса, предложения, цен и других экономических показателей. Также теория вероятности является основой такой науки как статистика. На формулах этого раздела математики построено так называемая теория игр.

Список литературы

1. Беляев Ю.К. и Носко В.П. «Основные понятия и задачи математической статистики.» - М.: Изд-во МГУ, ЧеРо, 2006.

2. В.Е. Гмурман «Теория вероятностей и математическая статистика. - М.: Высшая школа, 1997.

3. Корн Г.,Корн Т. «Справочник по математике для научных работников и инженеров. - СПБ:Издательство “Лань” 2003.

4. Пехелецкий И. Д. «Математика учебник для студентов.» - М. Академия, 2003.

5. Суходольский В.Г. «Лекции по высшей математике для гуманитариев.» - СПБ Издательство Санкт - Петербургского государственного университета. 2003;

6. Гнеденко Б. В. и Хинчин А. Я. « Элементарное введение в теорию вероятностей» 3 изд., М. - Л., 1952.

7. Гнеденко Б. В. «Курс теории вероятностей» 4 изд., М., 1965.

8. Феллер В. « Введение в теорию вероятностей и её приложение» (Дискретные распределения), пер. с англ., 2 изд., т. 1-2, М., 1967.

9. Бернштейн С. Н. « Теория вероятностей» 4 изд., М. - Л., 1946

|